AIAB 系统实验原理与架构解析

AIAB 系统实验原理与架构解析

系统核心定位与整体架构

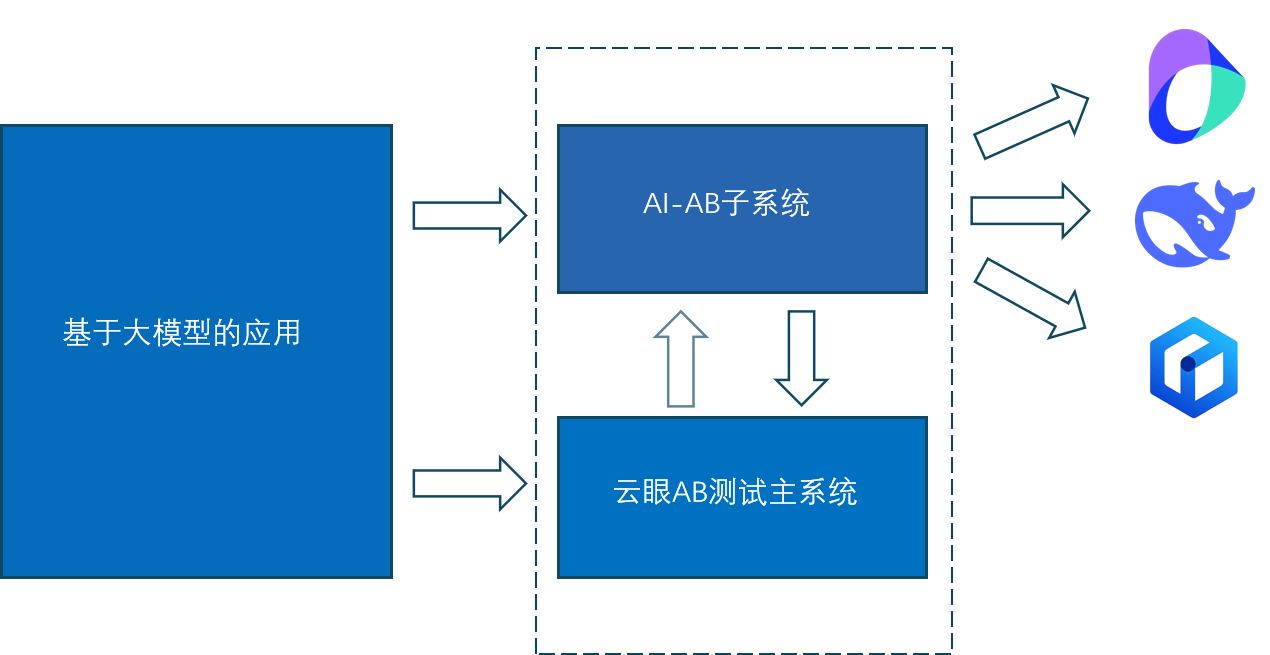

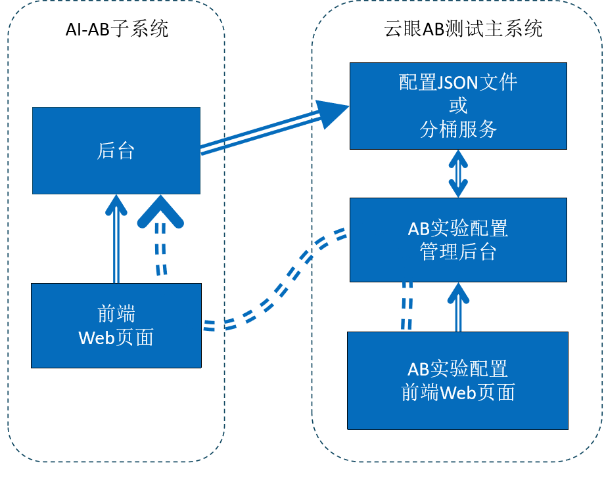

AIAB 系统(大模型应用专属 A/B 测试技术体系)是针对大模型应用从开发验证到上线迭代的全生命周期测试需求,构建的专业化技术方案,核心目标是解决传统测试方式在大模型场景下 “测试流程分散、决策依据模糊、流量管控低效” 的行业痛点。其架构基于 “前端交互 - 本地处理 - 后端管控” 的三层设计逻辑,形成 “AI-AB 子系统与云眼 AB 测试主系统” 的协同模式,与原理图呈现的模块分工及数据流向对应。

前端交互与本地分桶层(AIAB 子系统承载):作为用户与大模型应用的唯一交互入口,明确其功能边界 —— 仅提供 “聊天界面” 与 “用户评价” 两大核心交互功能,不包含任何实验配置相关操作入口;同时内置独立分桶模块,可自主完成流量分组计算,无需依赖云眼 AB 测试主系统实时传输参数或发起请求,实现 “交互与分桶” 的本地化闭环。

核心配置与分析层(云眼 AB 测试主系统承载):承担实验全流程的全局管控职能,是实验规则的唯一配置入口,负责分桶策略、流量占比、评估指标等核心参数的设置;同时接收 AIAB 子系统传输的数据,进行深度分析与结果展示,是实验科学性与可靠性的核心保障。

核心系统协同机制

AI-AB 子系统与云眼 AB 测试主系统的协同基于 “主系统配置管控、子系统执行反馈” 的原则,二者职能边界清晰且协作高效,确保每一项功能均能对应到具体模块,避免功能重叠或职责模糊。

AIAB 子系统

AI-AB 子系统作为 “用户与大模型应用的交互桥梁”,其核心职能严格限定在 “前端模块 + 分桶执行模块” 的功能范围内,无任何超额功能设计:

用户交互功能:前端 Web 页面仅保留 “聊天界面” 与 “用户评价入口”—— 用户通过聊天界面发起大模型调用请求(如智能问答),交互结束后可通过评价入口提交满意度反馈(如星级评分),不开放实验名称修改、流量占比调整等配置类操作,从源头避免非专业操作干扰测试流程,同时减少前端代码冗余,提升页面加载与响应速度。

内置分桶模块的独立执行:搭载本地化分桶计算模块,分桶逻辑完全基于云眼 AB 测试主系统预设的规则(如流量占比)。 当用户发起交互时,系统自动提取 “用户 ID”,调用内置分桶,结合主系统设置的测试组数量(如 A/B 两组、A/B/C 三组)与流量占比(如 A 组 40%、B 组 60%),计算并确定用户归属的测试组,同一用户在整个实验周期内始终归属同一测试组

全量数据采集与标准化上传:在用户交互过程中,自动采集四类核心数据,形成完整的测试数据链条。

- 用户标识数据:如用户 ID等,用于关联分桶结果与后续数据分析;

- 分桶结果数据:如归属测试组(A/B 组)、对应大模型版本(V1.0/V2.0);

- 交互内容数据:如用户提问内容、大模型回复文本、请求发起时间、响应完成时间(用于计算响应时长),判断大模型交互质量;

- 用户反馈数据:如满意度星级。

大模型请求转发适配:根据本地分桶结果,自动匹配对应版本大模型的接口信息(如接口地址、鉴钥等),将用户发起的原始请求转换为目标大模型可识别的格式,并通过内部通道转发至大模型;大模型返回结果后,系统将结果实时展示在聊天界面,整个过程对用户完全透明,不影响原有交互体验。

云眼 AB 测试主系统

云眼 AB 测试主系统作为 “实验全流程的管控核心”,其职能覆盖原理图中 “配置模块 + 数据接收模块 + 分析模块 + 结果模块” 的全链路,是确保测试科学性与决策有效性的关键:

实验全量配置管控:作为实验规则的唯一设置入口,通过主系统界面完成三类核心配置,所有配置结果直接决定 AIAB 子系统的分桶逻辑与数据采集维度:

- 测试对象配置:录入待测试的大模型版本信息,包括大模型名称、各种参数;

- 分桶规则配置:设定测试组数量(如 A/B 两组对比、A/B/C 三组对比)、各测试组流量占比(如 A 组 30%、B 组 70%),规则配置完成后直接作用于 AIAB 子系统的分桶模块,无需额外同步操作;

- 评估指标配置:定义测试的核心评估维度,包括技术指标(如响应时长、Token 消耗量、成本)与业务指标(如用户评分)。

数据接收与整合:通过专用数据接口接收 AIAB 子系统上传的全量数据,通过接口监听机制采集大模型的资源消耗数据(如单次调用的 Token 消耗量、计算成本、用户评分等),并将其与 AIAB 子系统传输的 “用户标识数据 + 分桶结果数据” 关联,形成 “用户 - 分桶 - 交互 - 资源消耗” 的完整数据集。

结果展示与决策支撑:将分析结果以 “可视化报告” 形式呈现:提供指标对比表(含均值)、趋势折线图(如每日响应时长变化)

所有报告仅在云眼 AB 测试主系统内展示,不向 AIAB 子系统同步,确保开发者可集中获取决策依据,避免多平台切换导致的效率降低。

全流程工作原理

AIAB 系统的工作流程围绕 “主系统配置管控 + 子系统本地执行” 的核心逻辑展开,每个环节均能对应到原理图中的模块与数据流向,实现 “配置 - 分桶 - 交互 - 分析 - 决策” 的完整闭环,确保测试流程可复现、可追溯:

实验配置

登录云眼 AB 测试主系统的配置管理界面,创建新实验并录入基础信息

完成测试对象配置:录入待测试的大模型版本信息,如模型名称、模型参数

设置分桶规则:选择测试组数量为 2 组(A 组对应 V1.0、B 组对应 V2.0),流量占比为 A 组 40%、B 组 60%

定义评估指标体系:技术指标、业务指标,设置指标阈值(如升高为优);

配置完成后,系统生成唯一实验 ID,并将分桶规则、测试对象信息等预设为 AIAB 子系统分桶模块的执行依据,整个过程与 AIAB 子系统无实时交互,仅通过系统初始化完成规则预置。

用户交互与本地分桶执行

用户打开基于大模型的应用,系统自动跳转至 AIAB 子系统的前端 Web 页面,仅展示 “聊天输入框”“历史对话区” 与 “满意度评价弹窗”;

用户在聊天输入框中输入需求,点击发送后,AI-AB 子系统前端将请求同步至后台,并自动提取用户 ID;

本地分桶模块启动计算:对用户进行分桶,获取分桶结果;

大模型请求转发:AIAB 子系统根据分桶结果,获取配置中的大模型信息,向实际的大模型发起请求

交互结果展示与反馈采集:AIAB 子系统前端将实际响应结果展示在历史对话区,同时弹出满意度评价弹窗,用户选择 “5 星” 并提交

数据上传与核心分析

AI-AB 子系统将分桶结果、响应时长、满意度评分(5 星)、token消耗数,成本等内容上传至云眼 AB 测试主系统;

云眼 AB 测试主系统接收数据后,自动关联从接口采集的 “Token 消耗量(如:180 Token)、调用成本”

结果展示

- 云眼 AB 测试主系统生成实验报告,报告中每个指标都有相关指标数据的折线图,直观的感受测试结果